Environment Recognition

What do we now see?

ロボットがより複雑な仕事をこなすようになるためには,今センサで見えているものが何かがわかり,ロボットが置かれた状況を理解できる必要があります.Team AMSL Racingでは主に画像を用いて研究をしています.ここでその一部を紹介しましょう.

Classification by 3D Information

まずは3次元情報を使った方法から.Fig.1は,なだらかな上り坂をステレオカメラで撮影した写真の一枚です.この写真と対をなすステレオペアの写真を用いて3次元復元処理を行い,地形解析を行います.

Fig.1 なだらかな斜面と段差のある地形

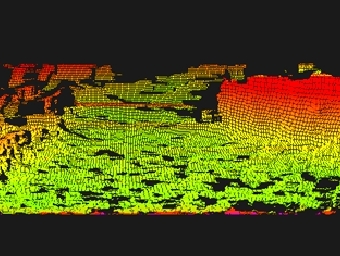

Fig.2 ステレオ処理による3次元復元モデル

Fig.2 はステレオ処理によって復元した地形の3次元モデルです.元の画像よりも若干低い視点から見た様子です.3次元モデルなので,あらゆる方向から見ることが出来ます.またこのモデルデータと,ロボットに備わっている傾斜角センサを用いて,主に高さ情報を元にして「通りやすさ・通りにくさ」の情報を得ることができます(Fig.3).

Fig.3 高さ情報をベースに「通りにくさ」情報を取りだしたマップ

Classification by Textured Images

この様なことは,ステレオカメラの精度が十分発揮できる10数m以内の距離までなら有効に機能します.しかし,広い自然環境の中で,ロボットそれ自体が置かれた状況を把握するためには,もっと遠距離での環境理解が必要になります.また,数キロメートル以上離れた所までプランニングして自律移動したい場合,当然ながらステレオカメラによる3次元モデルは使えません.このような時,2次元画像からtexture(模様)を用いて,「そこが何であるか」を判別することができれば,見渡す限りの地形に対して,非常に有用な情報を得ることが出来るようになります.

Fig.4 Terrain Classification by Textured Patches

Fig.4 は,Fig.1の2次元情報のみから環境の判別を行った例です.元の絵に,走行不能領域と判別されたところを赤く,走行可能領域と判別されたところを青く塗っています.